Nonostante la continua crescita del cloud, molte aziende stanno tenendo i loro data center. Attualmente, anche i modelli di volume dei produttori affermati stanno aumentando. Allo stesso tempo, la tendenza verso i concetti di cloud ibrido e as-a-service continua.

Nella maggior parte delle aziende, i propri data center o, nel caso delle aziende più piccole, le sale server costituiscono ancora la spina dorsale della loro infrastruttura IT. Anche se il business del cloud, soprattutto sotto forma di grandi hyperscaler, è ancora in rapida crescita, il business tradizionale dei server rimane intatto anche nel canale IT locale. La maggior parte delle aziende tende ad affidarsi al cloud ibrido invece di esternalizzare tutte le applicazioni e i dati al cloud pubblico. Nel nostro sondaggio su questo canale, il 45% di tutte le case di sistema intervistate ha valutato il business dei server come molto importante e un altro 35% come importante per il loro business. Allo stesso tempo, il 65% delle case di sistema dichiara che l'integrazione in un'infrastruttura di cloud ibrido è di alta o molto alta importanza per i loro clienti.

Ci sono varie ragioni per attenersi alla propria infrastruttura di server. Alcuni clienti sono preoccupati per la conformità con le soluzioni di cloud pubblico, mentre altri si affidano a soluzioni industriali per il loro software che non possono essere spostate nel cloud, o solo con difficoltà. E poi ci sono applicazioni che è meglio eseguire localmente per ragioni di prestazioni. Questo include il crescente numero di applicazioni edge, dove i dati sono pre-elaborati sui server entry-level.

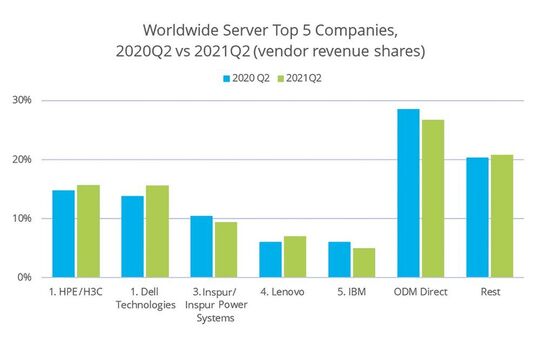

Secondo l'IDC Worldwide Quarterly Server Tracker, il mercato globale dei server è diminuito del 2,5 per cento nel secondo trimestre del 2021, ma è ancora ad un livello complessivo elevato con vendite di 23,6 miliardi di dollari. Il numero di sistemi venduti è cresciuto anche minimamente dello 0,1 per cento. La perdita è interamente dovuta a Inspur, ai produttori ODM e a IBM. HPE, Dell e Lenovo, i tre grandi produttori affermati di server x86, d'altra parte, sono stati in grado di fare guadagni. Inspur e gli ODM avevano beneficiato molto dell'espansione dei data center dei grandi fornitori di cloud negli ultimi anni. Le minori entrate derivano dalla maggiore quota di sistemi a singolo socket più economici.

Il data center sta diventando simile al cloud

Nel settore enterprise o nelle grandi aziende mid-market, il data center in-house sta diventando più simile al cloud. La modularizzazione e la ricollocazione delle applicazioni in container permette di distribuire le applicazioni più velocemente. Inoltre, la gestione dell'hardware e del software è automatizzata il più possibile. Questo ha anche lo scopo di eliminare la separazione tra sviluppo e operazioni per ottenere un modello operativo più agile. Un'importante adozione dal mondo del cloud è "Infrastructure as Code" (IaC) come ulteriore sviluppo della gestione della configurazione dei server. Anche le soluzioni di orchestrazione come Kubernetes, che sono già integrate da diversi produttori di server nelle loro piattaforme di gestione dei dispositivi, stanno diventando sempre più importanti. Questo ha lo scopo di gestire insieme i cluster distribuiti di Kubernetes attraverso i vari ambienti nel cloud ibrido.

Qui, le soluzioni di infrastruttura iperconvergenti sono la prima scelta per molte aziende, poiché il funzionamento degli approcci DevOps con un'infrastruttura server convenzionale esistente è spesso difficile da realizzare a causa della mancanza di interfacce adatte all'automazione. Importanti fornitori di soluzioni software HCI come VMware o Nutanix hanno già ampliato le loro piattaforme di conseguenza. Con la Tanzu Application Platform, VMware ha ulteriormente ampliato la propria soluzione Kubernetes, Nutanix lavora a stretto contatto con Red Hat per l'utilizzo di OpenShift. Con Azure Stack HCI, Microsoft offre anche una soluzione HCI per On Premises come servizio, che può essere utilizzato su molti sistemi e naturalmente è particolarmente adatto per l'integrazione con Azure Cloud.

Uno svantaggio dell'HCI, la mancanza di scalabilità orizzontale, dovrebbe essere rimediato dall'Infrastruttura Composibile (CI). Questo si riferisce a sistemi con un alto grado di astrazione che aggregano risorse IT come potenza di calcolo, storage e rete da un pool dinamico in base alle esigenze del carico di lavoro e le ritrasferiscono nel pool alla fine dell'utilizzo.

Tra i partner che abbiamo intervistato, ben il 69% ritiene che la CI abbia le carte in regola per sostituire in futuro i sistemi convergenti o iperconvergenti oggi in uso.

Il ritorno dei coprocessori

Anche l'attuale tendenza di esternalizzare l'intelligenza ai singoli componenti per alleggerire il processore principale si inserisce in questa tendenza. Un esempio è rappresentato dalle DPU (Data Processing Unit), che sono un ulteriore sviluppo delle Smart NIC utilizzate da tempo, soprattutto nei data center degli hyperscaler. Le DPU sono schede di rete ancora più intelligenti sulle quali, oltre all'FPGA, c'è anche una CPU e a volte anche una GPU. I produttori importanti qui sono Nvidia con Mellanox, Broadcom, Marvell, Xilinx, la start-up Fungible e recentemente anche Intel. Le DPU assumono compiti di elaborazione dei pacchetti nella rete dalle CPU dei server, il che può comportare un carico considerevole a 100 GBit e con tecnologie come gli switch virtuali. Questo è specialmente il caso delle infrastrutture containerizzate con un gran numero di microservizi.

Questo rende queste carte interessanti per gli utenti aziendali. In futuro, gli SSD sempre più veloci con FPGA integrati dovrebbero anche alleggerire il processore principale in compiti come l'analisi dei dati o la ricerca in grandi set di dati. Tali tecniche sono utilizzate principalmente dai grandi fornitori di cloud, poiché possono adattare e ottimizzare le loro applicazioni di conseguenza. Ma con il tempo, saranno supportati anche da software standard e quindi troveranno la loro strada anche nei data center più piccoli.

Secondo Concat, le soluzioni iperconvergenti e i data center come servizio sono adatti anche alle PMI, purché le condizioni quadro siano adatte. Alle nostre domande rispondono Stefan Voigt, Account Manager, e Julian Anstätt, Senior Consultant As-a-Service di Concat.

ITB: In che misura le soluzioni iperconvergenti hanno ormai un ruolo anche per i clienti dell'ambiente delle PMI? C'è una tendenza ad abbandonare le soluzioni server tradizionali?

Voigt: Questo dipende molto dal singolo caso. L'HCI sta diventando sempre più importante, ma non si adatta a tutti i clienti. Entrambi i concetti hanno la loro ragion d'essere. Tuttavia, i vantaggi dell'iperconvergenza sono così convincenti che vale la pena anche per le piccole e medie imprese considerare questa tecnologia. Avere il calcolo, lo stoccaggio e la rete in un unico sistema semplifica e automatizza la manutenzione e la gestione. La tolleranza d'errore integrata assicura anche una maggiore disponibilità. Tuttavia, la relazione tra i requisiti di calcolo e di storage deve essere giusta!

ITB: Alcuni produttori stanno ora promuovendo anche concetti as-a-service per i data center dei clienti. Vedete anche qui una domanda tra i clienti delle medie imprese, o offrite tali soluzioni per questa clientela?

Anstätt: Sì, la domanda c'è sicuramente, ed è anche in aumento. Due ragioni possono essere identificate qui: I clienti delle PMI hanno spesso un'alta pressione sui costi. Inoltre, a causa della digitalizzazione, hanno difficoltà a prevedere con precisione la crescita del loro IT con cinque anni di anticipo. Ecco perché l'approccio as-a-service è così interessante per le PMI. Offriamo queste soluzioni da più di cinque anni. Tuttavia, la variante on-premises è redditizia solo per 300 o più posti IT, perché altrimenti i costi di base sono troppo alti. Più piccolo è l'IT del cliente, più alti sono i costi. È per questo che gestiamo le nostre infrastrutture nei data center tedeschi per le piccole e medie imprese, in modo da poter fornire loro capacità IT che sono esattamente su misura per le loro esigenze. In questo modo, i costi di base sono distribuiti su più clienti, e questo lo rende accessibile alle PMI.

Il proprio data center come servizio

Il prestito dal cloud non arriva solo nei data center locali sotto forma di tecnologie, ma anche nei modelli di business. Le offerte Device-as-a-service come HPE Greenlake, Dell Apex e, più recentemente, Fujitsu uScale stanno introducendo modelli di utilizzo e fatturazione simili al cloud, che dovrebbero portare ai clienti una maggiore flessibilità e minori investimenti una tantum. Tuttavia, il downscaling in particolare non è così facile, poiché le risorse hardware che non sono più utilizzate si trovano nel data center del singolo cliente e non possono essere utilizzate per i carichi di lavoro di altri clienti come nel cloud pubblico. Pertanto, c'è sempre un importo base mensile e termini minimi per le offerte Device-as-a-Service.

In cambio, le offerte di abbonamento includono già l'installazione e la configurazione dopo l'ordine, nonché la manutenzione e il supporto durante il funzionamento. Attraverso una piattaforma di gestione, il dipartimento IT delle aziende o una system house che assume il supporto IT ottiene una visione dettagliata delle risorse utilizzate e dei costi che ne derivano. Inoltre, le piattaforme self-service basate sul cloud sono destinate a rendere l'uso di applicazioni simili a quelle del cloud pubblico. I clienti devono solo specificare che tipo di applicazioni vogliono eseguire, per esempio carichi di lavoro di calcolo, applicazioni data-intensive o applicazioni AI, di quante istanze hanno bisogno e la durata del contratto. In base a questo, l'hardware ottimale per loro viene messo insieme e installato senza che i clienti debbano preoccuparsi dei sistemi specifici.

Con l'HCI, anche le piccole e medie imprese possono portare il cloud nel proprio data center. E il Capex sta diventando sempre più importante anche per le medie imprese, spiega Stefan Langhirt in un'intervista. È responsabile delle operazioni commerciali alla Profi AG.

ITB: In che misura le soluzioni iperconvergenti giocano ora un ruolo anche per i clienti dell'ambiente delle PMI? C'è una tendenza ad abbandonare le soluzioni server tradizionali?

Langhirt: Le PMI in particolare devono affrontare la sfida di dover gestire sistemi sempre più complessi con diversi componenti hardware, di rete e di virtualizzazione con un team IT per lo più piccolo. Inoltre, i requisiti dei dipartimenti specializzati per quanto riguarda la scalabilità e la fornitura veloce di risorse CPU e capacità di archiviazione sono in costante aumento. Poiché in un sistema HCI questi componenti sono combinati in un sistema definito dal software, possono essere gestiti facilmente e centralmente, l'IT guadagna notevolmente in efficacia ed efficienza. Un altro vantaggio è che una soluzione HCI crea una buona base per rendere le classiche infrastrutture di server e di storage nel data center capaci di fare il cloud. In un mondo agile, la trasformazione di applicazioni e processi può essere implementata rapidamente e con successo solo se l'IT sottostante può essere fornito in modo flessibile e automatizzato. Con i sistemi iperconvergenti e il corrispondente middleware, il dipartimento IT può costruire in modo relativamente rapido e semplice un'infrastruttura cloud nel proprio data center e offrire ai dipartimenti aziendali degli SLA simili a quelli dei fornitori di cloud pubblici - il che naturalmente rende il passo successivo, cioè spostare i carichi di lavoro sul cloud pubblico, molto più facile. Questo è esattamente il motivo per cui Nutanix ha rinominato HCI da "Hyperconverged Infrastructure" a "Hybrid Cloud Infrastructure" qualche tempo fa.

ITB: Alcuni produttori stanno promuovendo concetti as-a-service per i data center dei clienti. Vedete anche qui una richiesta tra i clienti delle medie imprese o offrite tali soluzioni per questa clientela?

Langhirt: La tendenza dal capex all'opex è evidente anche tra molti clienti di medie dimensioni e si può osservare sempre più spesso anche nell'infrastruttura IT. Purtroppo, i molti modelli sono ancora molto individuali e difficili da confrontare, quindi c'è ancora bisogno di un chiarimento. Anche i costi sottostanti e le strutture dei prezzi non sono molto trasparenti, quindi bisogna valutare attentamente il business case - anche le offerte IaaS degli hyperscalers possono essere alternative sensate. In ogni caso, stiamo osservando questo sviluppo molto da vicino per poter consigliare i nostri clienti in modo ottimale in futuro su quali alternative sono l'approccio giusto per loro.

Tendenze attuali e future nei processori per server

Ci sono molte cose da fare al momento. AMD è riuscita a raddoppiare le sue vendite totali negli ultimi mesi. Nel frattempo, il produttore è stato anche in grado di aumentare significativamente le vendite di processori Epyc. Il segmento dei processori enterprise, embedded e semi-custom, che oltre a Epyc include anche le APU nelle console, è recentemente cresciuto del 69%. Nelle CPU per server, la domanda degli hyperscaler ha giocato un ruolo importante, dove Intel ha subito un calo del 20% nell'ultimo trimestre.

D'altra parte, il produttore di processori ha avuto successo nell'ultimo trimestre con i nuovi Xeon Ice Lake per clienti aziendali e nel settore pubblico. Sono i primi processori server a 10nm di Intel e si avvicinano alle prestazioni per core degli attuali processori AMD Epyc della serie Milan. Tuttavia, AMD ha ancora il vantaggio con questi ultimi di poter offrire modelli fino a 64 core, mentre con Ice Lake SP il capolinea è già raggiunto con 40 core. Rispetto ai predecessori Cooper Lake e Cascade Lake con fino a 28 core per die, tuttavia, questo è ancora un grande passo avanti.

All'inizio del 2022, la prossima generazione di Xeon sarà lanciata con Sapphire Rapids e riconquisterà la corona delle prestazioni per Intel. Il processore, che come Alder Lake è prodotto con il processo Intel 7, non è più costruito monoliticamente ma è composto da diverse piastrelle. In totale, saranno presumibilmente possibili fino a 60 core per processore. Sono basati sull'architettura Golden Cove, che Intel utilizza anche per i core di prestazioni dei processori Alder Lake Core. In aggiunta, comunque, ci sono altre caratteristiche che migliorano le prestazioni come il supporto per la memoria DDR5 con quattro controller di memoria e otto canali di memoria, la connessione diretta di moduli HBM e il supporto per PCIe 5.0. Ultra Path Interconnect (UPI) 2.0 dovrebbe garantire una migliore scalabilità nei sistemi multi-socket, e il supporto per Compute Express Link (CLX) 1.1 dovrebbe garantire la connessione veloce degli acceleratori.

AMD non ha ancora rilasciato dichiarazioni concrete sui prossimi modelli Epyc. Tuttavia, ci sono indicazioni che Milano-X sarà una tappa prima del passaggio a Zen 4. L'uso della cache 3D dovrebbe permettere ai processori Epyc con 768 invece di 256 MB di cache di livello 3. Qui, i chip di memoria aggiuntivi sono applicati direttamente ai CCD (Compute Core Dies) con l'aiuto di una tecnologia di impilamento sviluppata insieme a TSMC. Più tardi nel corso dell'anno, seguirà il processore Zen 4 Epyc Genoa con DDR5 e AVX-512. Le voci parlano di un massimo di 96 core.