Con la A100, Nvidia presenta la prima GPU con architettura Ampere. L’enorme chip da 7nm si dice che non sia solo significativamente più potente, ma anche molto più flessibile del suo predecessore Volta. Con DGX A100, HGX A100 e EGX A100, ci sono piattaforme per i data center e l’edge computing.

L’eponimo dell’architettura Ampere di Nvida è il fisico e matematico francese André-Marie Ampère, da cui l’unità di amperaggio Ampere prende il nome. Il nome calza a pennello, perché il processore Ampere A100 di Nvidia è di gran lunga la GPU più potente mai realizzata. In alcune applicazioni, si dice che sia fino a 20 volte più veloce del suo predecessore Volta, secondo Jensen Huang, fondatore e CEO di Nvidia.

Al confine della tecnologia a 7 nm

Al contrario del suo predecessore V100 con architettura Volta, l’A100 non è più prodotto a TSMC in 12 nm, ma in 7 nm. Con una superficie di 826 mm², il chip Ampere è comunque più grande. Il numero di transistor è aumentato da 21,1 miliardi a 54 miliardi rispetto al V100. Questo pone il chip al limite di ciò che è fattibile con 7 nm, secondo Huang.

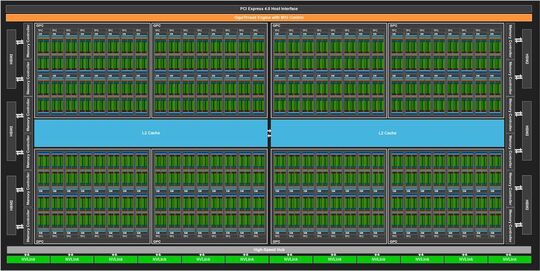

L’A100, come prima implementazione dell’architettura hardware GA100 con in principio fino a 128 streaming multiprocessori (SM), ha 108 SM attivi. Questi sono divisi in 3.456 core FP64 e 6.912 core FP32. Mentre il numero di core FP64 e FP32 è aumentato considerevolmente rispetto al GV100, Nvidia ha ridotto il numero di core tensori da 640 a 432. Tuttavia, questi Tensor Core di terza generazione si dice siano significativamente più potenti, soprattutto per le applicazioni AI, perché possono gestire Tensor Float 32 (TF32), un nuovo formato in virgola mobile che combina la gamma di dati di FP32 e la precisione di FP16. Rispetto a Volta, si suppone che Ampere sia più veloce di un fattore 20 nell’addestramento AI con bassa precisione. Sparcity è un approccio relativamente nuovo all’ottimizzazione delle reti neurali profonde. Con l’architettura GA100, Nvidia introduce la Structural Sparsity Acceleration: nuove istruzioni Sparse Tensor Core che raddoppiano il throughput delle operazioni con matrici sparse nei formati TF32, FP16, BFLOAT16, INT8 e INT4. Inoltre, i carichi di lavoro devono essere meglio distribuiti tra i singoli nodi.

Inoltre, i Tensor Core accelerano FP64 per applicazioni HPC. Così, secondo Nvidia, un A100 esegue 19,5 TFOPS rispetto a 7,8 TFLOPS per il chip V100.

La cache di livello 2 di A100 è di 40MB, 6,7 volte più grande di quella della V100 e divisa in due partizioni per aumentare la larghezza di banda e ridurre la latenza.

Con sul pacchetto GPU 40 GB di memoria veloce HBM2 sotto forma di cinque stack con otto die di memoria per stack. Nvidia dichiara una larghezza di banda di memoria di 1.555 GB/s, 1,7 volte superiore a Volta. Il modulo SXM4 con la GPU A100 ora supporta PCI Express 4.0, e NVLink 3.0 è usato per comunicare più chip A-100, due volte più veloce di NVLink 2.0 a 600 GB/s.

Il supporto API per le innovazioni di Ampere è incluso in Cuda 11. Inoltre, Nvidia offre contenitori ottimizzati per GPU per applicazioni di deep learning, machine learning e HPC che già includono il toolkit Cuda 11. Sono solo una parte dello stack software completo, che include anche modelli pre-addestrati.

Fino a sette GPU in una

Per rendere più flessibili i sistemi con GPU A100, la nuova funzione Multi-Instance GPU (MIG) permette a ogni GPU di essere suddivisa in un massimo di sette istanze GPU separate, ciascuna progettata per fornire le prestazioni di una V100 per applicazioni specifiche. Ogni istanza ha i suoi percorsi nel sistema di memoria completo. Con MIG, le singole VM o contenitori possono utilizzare le istanze in isolamento e con QoS definite. Questo è particolarmente importante per i fornitori di servizi. In un sistema DGX-A100 o un sistema OEM con otto GPU ciascuno, MIG può anche essere attivato selettivamente su singole GPU.

Sistemi di amplificazione per il data center

Nvidia non offre la GPU A100 per l’uso nei data center come scheda plug-in, ma solo come sistema completo DGX-A100 o come schede dotate di diverse GPU per i produttori OEM. Il DGX A100 è già la terza generazione DGX di Nvidia. Secondo il produttore, il sistema è il primo server 5-petaFLOPS al mondo. Il CEO di Nvidia Huang spiega che un data center con cinque sistemi DGX-A100 per l’addestramento e l’inferenza AI ha circa le stesse prestazioni di un precedente data center con 50 sistemi DGX-1 per l’addestramento e server aggiuntivi con circa 600 CPU per i compiti rimanenti. I cinque server DGX-A100 richiedono 28 KW e costano circa un milione di dollari, mentre il precedente data center costava più di 11 milioni con un consumo energetico di 630 KW. Per esigenze estreme, Nvidia offre un DGX SuperPOD con 140 sistemi DGX-A100 e 700 PetaFLOPS. I singoli sistemi sono collegati da componenti di rete di Mellanox. Nvidia ha recentemente acquisito Mellanox.

In un singolo sistema DGX-A100 in un fattore di forma 4U, ci sono otto GPU A100 interconnesse da sei NVSwitch tramite NVLink 3.0. Siedono su una scheda madre con due attuali processori AMD Epyc 7742 della generazione Rome con 64 core ciascuno. Intel, il fornitore del processore per i precedenti sistemi DGX, non ha ancora alcun processore con supporto PCI Express 4.0 nel suo portafoglio. Questo arriverà solo con Ice Lake SP più tardi quest’anno.

La memoria principale sulla scheda madre è di un TB, la memoria di massa consiste in SSD PCIe 4.0 con 15 TB di capacità totale. La connettività di rete è fornita da otto ConnectX-6 VPI a porta singola di Mellanox per 200Gb/s HDR Infiniband e un ConnectX-6 VPI a doppia porta per 200Gb/s Ethernet.

Per i fornitori di cloud che hanno i propri server assemblati o per i produttori OEM, Nvidia offre due diverse baseboard HGX-A100. La variante grande è dotata di otto GPU e progettata per sistemi con due CPU, quella piccola con quattro è destinata a sistemi a singola CPU. La connessione alle schede madri con CPU e RAM è stabilita tramite PCI Express in ogni caso.

Secondo Nvidia, i sistemi con HGX A100 verranno dai produttori Atos, Cray, Dell, Fujitsu, Gigabyte, HPE, Inspur, Lenovo, QCT e Supermicro. Nvidia nomina Alibaba, AWS, Baidu, Google, Microsoft Azure, Oracle e Tencent come fornitori di cloud con sistemi A100.

Ampliare l’edge computing

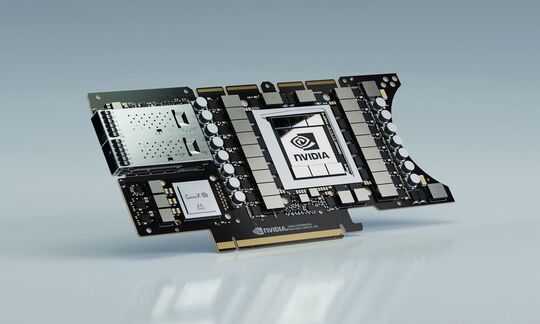

Per le applicazioni al bordo della rete, Nvidia sta portando a bordo la scheda plug-in EGX A100 PCIe con una GPU A100 e una Mellanox ConnectX-6 DX per 100Gb/s Ethernet o Infiniband. Nvidia nomina smart citiy, medicina, infrastruttura 5G, riconoscimento vocale, robotica e guida autonoma come aree di applicazione. Nvidia fornisce framework applicativi per tutti questi settori. Mentre i sistemi DGX-A100 sono già presso i clienti, le schede EGX-A100 dovrebbero essere disponibili entro la fine dell’anno.