Il Software as a Service è in piena espansione. Il traffico di dati, i carichi di lavoro e i dati tendono quindi a migrare dal data center dell’azienda verso il cloud. Qui sono necessari nuovi concetti di backup. Ma ci sono anche opportunità per ripensare vecchi concetti.

Nel contesto dello storage, il cloud e il suo trionfo tecnologico stanno completamente arando il paesaggio IT. Lo spostamento dei processi di lavoro e dei carichi di lavoro attraverso sistemi produttivi come Microsoft 365 tra cui Teams o applicazioni SaaS come Salesforce al cloud sta lasciando solchi profondi. La tendenza verso l’home office in particolare ha alimentato questo sviluppo.

La fiducia è buona…

Anche se Microsoft protegge i dati non strutturati che si accumulano nell’ambiente 365, per esempio documenti o mail creati in comune, in un data center del produttore in un modo che le piccole e medie imprese devono prima gestire in termini di sicurezza e disponibilità. Tuttavia, questo è solo un backup di base, e nonostante la duplicazione dei dati dei clienti su diversi server Microsoft, non tutti gli scenari di perdita di dati sono coperti. Per esempio, il contenuto perso, cancellato o corrotto è responsabilità del cliente.

Il controllo è meglio…

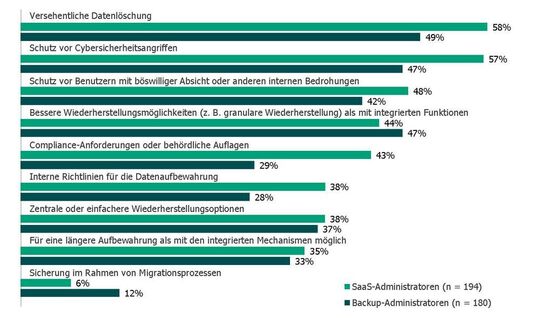

La cancellazione accidentale dei dati da parte dell’utente o dell’amministratore, o l’azione dolosa, per esempio per vendicarsi del datore di lavoro, sono solo due dei tanti scenari che gli amministratori di backup SaaS e tradizionali nelle aziende conoscono bene, secondo un sondaggio commissionato dalla società di protezione dei dati Veeam.

Gli amministratori sul backup dei dati cloud

Gli amministratori di SaaS e Microsoft 365 sono ben consapevoli della necessità di eseguire il backup dei dati cloud. Come ha scoperto Veeam in uno studio commissionato, gli amministratori SaaS e i responsabili del backup ritengono che i meccanismi di disponibilità integrati di Microsoft 365 non siano sufficienti, per le stesse ragioni. Di conseguenza, i dati devono continuare ad essere salvati nel modo tradizionale. Tuttavia, gli amministratori di SaaS e di backup hanno pesato le ragioni di questo in modo diverso.

La concorrenza stimola il business

È un fallimento da parte di Microsoft non offrire una soluzione di backup più granulare per M365 qui? No, nel senso di un’economia di piattaforma, il gruppo IT si affida a produttori che hanno specializzato e dock le loro soluzioni. Per proteggere completamente i dati nel cloud, è concettualmente necessaria una soluzione di terze parti. Questo è ora fatto dai produttori di sicurezza; dal lato del provider, per esempio, da un’offerta completa di Deutsche Telekom o da servizi che i Managed Service Provider mettono insieme in un pacchetto globale.

L’1 dalla regola del backup

La regola del backup 3-2-1 per la protezione dei dati gioca un ruolo nell’altra direzione. Nell’era del cloud, non è solo una sfida fare il backup dei dati dal cloud computing in modo convenzionale, ma anche un’opportunità per fare il backup del cloud in termini di “1” dalla regola del backup: Dovrebbero essere fatte tre copie. Le copie dovrebbero essere memorizzate su due diversi tipi di supporti di memorizzazione, e una copia dei dati dovrebbe essere conservata in un luogo fuori sede.

Allora la nuvola si suggerisce letteralmente da sola per quanto riguarda il luogo di stoccaggio esterno. Dopotutto, chi preferirebbe invece spostare i dischi hardware in giro, bunkerarli altrove giorno dopo giorno? Alcuni sistemi di backup ora hanno l’opzione che, non appena viene eseguito un backup on-premises, viene eseguito anche un backup cloud allo stesso tempo.

Se la probabilità di fallimento di una copia è 1/ 100, questa scende a: 1/ 100 * 1/ 100 = 1/ 10.000 per due sistemi. Per un terzo sistema, scende a 1/ 1.000.000.

Anche l’amministratore ha dei limiti

Per essere in acque sicure dal punto di vista della Complance fin dall’inizio, alcuni provider offrono la possibilità di utilizzare la funzione “S3 Object Lock” su AWS. Con questa funzione, non è più possibile per nessuno, nemmeno per l’amministratore, cambiare o cancellare i dati. Questo assicura un’archiviazione a prova di audit, che è anche una buona alternativa al backup su nastro, che poi non deve più essere spostato in altre posizioni in linea con la regola del backup.

Informazioni supplementari

Commento: Dischi immortali grazie a Save-Icon

I floppy disk conservati in modo ottimale e protetti dalla luce solare e dal magnetismo dovrebbero superare periodi di conservazione fino a 30 anni. Quindi, teoricamente, alcuni potrebbero essere ancora in uso. In pratica, questa tecnologia obsoleta non gioca più un ruolo in nessun concetto serio di gestione dei dati.

Si dice che ci sono persino giovani impiegati che, vedendo un floppy disk da 3,5 pollici, hanno chiesto se si tratta di una stampa 3D di un simbolo di archiviazione. Nel regno dei simboli, dopo tutto, il floppy disk si sta godendo il suo meritato pensionamento, servendo a salvare i dati ogni volta che si clicca sulla voce salva.

O, per riassumere con una frase inappropriata e patetica che ha infestato internet per anni, “I floppy disk sono come Gesù: sono morti per diventare l’icona del risparmio.”

Il cloud non è una strada a senso unico

Nell’interazione tra il data center e il cloud, l’aumento dell’utilizzo del cloud non significa che il data center sia diventato obsoleto, ha detto Veeam nello studio. Piuttosto, l’aggiunta di server ospitati nel cloud porta a una diminuzione della proporzione di server fisici o virtuali nell’ambiente del data center. Solo il 62% dei server ospitati nel cloud sono stati migrati fuori dal data center nel tempo. Il restante 38% è stato invece impostato direttamente nel cloud. Se i risultati dello studio sono da credere, diventa evidente che la migrazione dall’ambiente locale al cloud non è sempre una strada a senso unico. Secondo lo studio, il 58% delle aziende non ha migrato i carichi di lavoro dal cloud all’ambiente locale, ma il 42% lo ha fatto. Quindi, nonostante il clamore del cloud, il data center è lontano dall’essere obsoleto.

Cambiamento tecnologico

In termini di Kubernetes, la gestione dello storage continua a guadagnare importanza. I container volatili giocano un ruolo negli ambienti Kubernetes, e il focus fin dall’inizio non è sull’infrastruttura ma sulle applicazioni. Proteggere i dati anche all’interno dei container (e non solo nel repository di stoccaggio) è una sfida su cui attualmente si concentra molto potere di sviluppo.